中國AI公司MiniMax正式宣佈開源其最新大型語言模型(LLM)MiniMax-M1,該模型以超長上下文推理能力和高效訓練成本引發全球關注。AIbase整理最新信息,爲您帶來MiniMax-M1的全面解讀。

創紀錄的上下文窗口:1M輸入,80k輸出

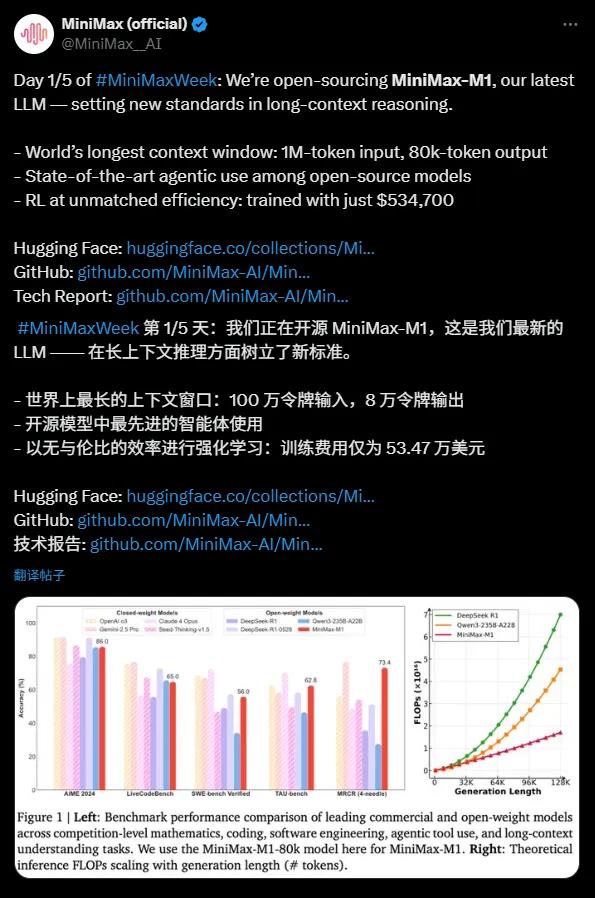

MiniMax-M1以其驚人的100萬token輸入和8萬token輸出的上下文窗口,成爲目前開源模型中最擅長長上下文推理的佼佼者。這一能力意味着模型能夠一次性處理相當於一本小說甚至整個書系列的信息量,遠超OpenAI GPT-4o的128,000token上下文窗口。無論是複雜文檔分析、長篇代碼生成,還是多輪對話,MiniMax-M1都能遊刃有餘,爲企業和開發者提供了強大的工具。

開源模型中的代理能力先鋒

MiniMax-M1在代理工具使用方面表現卓越,性能媲美頂級商業模型如OpenAI o3和Claude4Opus。得益於其混合專家模型(MoE)架構與Lightning Attention機制的結合,MiniMax-M1在複雜任務如軟件工程、工具調用和長上下文推理中展現出接近最先進的性能。這種開源模型的強大代理能力,爲全球開發者社區帶來了前所未有的機會。

超高性價比:53萬美元打造前沿LLM

MiniMax-M1的訓練成本令人矚目,僅需53.47萬美元,相比DeepSeek R1的500-600萬美元和OpenAI GPT-4的超1億美元,堪稱“平價奇蹟”。通過高效的強化學習(RL)技術和僅512個H800GPU的硬件支持,MiniMax在短短三週內完成了模型開發。此外,MiniMax首創的CISPO優化算法進一步提升了推理效率,確保重要信息不丟失,同時降低訓練成本。

技術亮點:456億參數與高效架構

MiniMax-M1基於MiniMax-Text-01開發,擁有4560億總參數,每個token激活約45.9億參數,通過MoE架構實現高效計算。模型支持40k和80k思維預算的兩種推理模式,滿足不同場景需求。在數學、編碼等推理密集型任務的基準測試中,MiniMax-M1表現強勁,超越了DeepSeek R1和Qwen3-235B-A22B等模型。

開源生態的里程碑

MiniMax-M1採用Apache2.0許可證,已上架Hugging Face平臺,供全球開發者免費使用。這一舉措不僅挑戰了DeepSeek等中國AI企業的開源模型,也爲全球AI生態注入了新的活力。MiniMax表示,未來還將發佈更多技術細節,進一步推動開源社區的創新。

MiniMax-M1的發佈標誌着開源AI模型在長上下文推理和代理能力上的重大突破。其超長上下文窗口、高效訓練成本和強大性能,爲企業和開發者提供了極具性價比的解決方案。AIbase認爲,MiniMax-M1的開源將加速AI技術在複雜任務中的應用,推動全球AI生態邁向新高度。