英偉達在GB200和B200發佈僅6個月後,再次推出全新GPU——GB300和B300。這看似只是小幅升級,實則蘊含着巨大的變革,尤其是推理模型性能的顯著提升,將給整個行業帶來深遠的影響。

B300/GB300:推理性能的巨大飛躍

B300GPU採用臺積電4NP工藝節點,針對計算芯片進行了優化設計。這使得B300的FLOPS性能比B200提升了50%。部分性能提升來自TDP的增加,GB300和B300HGX的TDP分別達到1.4KW和1.2KW(GB200和B200分別爲1.2KW和1KW)。其餘的性能提升則來自架構增強和系統級優化,例如CPU和GPU之間的動態功率分配。

除了FLOPS的提升,內存也升級爲12-Hi HBM3E,每個GPU的HBM容量增加到288GB。然而,引腳速度保持不變,因此每個GPU的內存帶寬仍爲8TB/s。值得注意的是,三星未能進入GB200或GB300的供應鏈。

此外,英偉達在定價方面也做出了調整。這將在一定程度上影響Blackwell產品的利潤率,但更重要的是,B300/GB300的性能提升將主要體現在推理模型方面。

爲推理模型量身打造

內存的改進對於OpenAI O3風格的LLM推理訓練至關重要,因爲長序列會增加KVCache,從而限制關鍵批處理大小和延遲。從H100到H200的升級(主要是內存的增加),帶來了以下兩方面的改進:

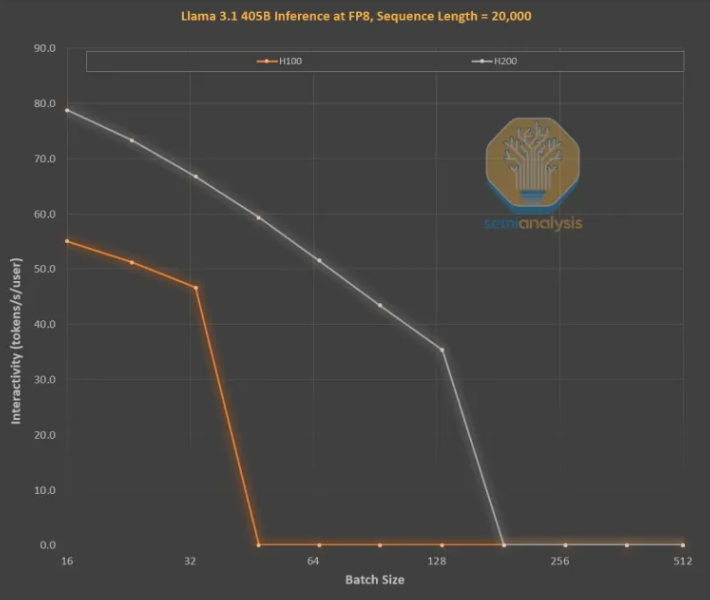

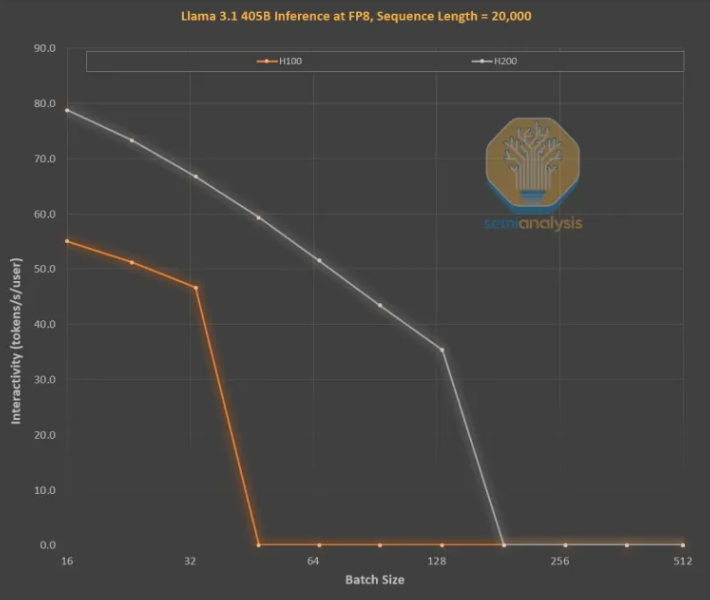

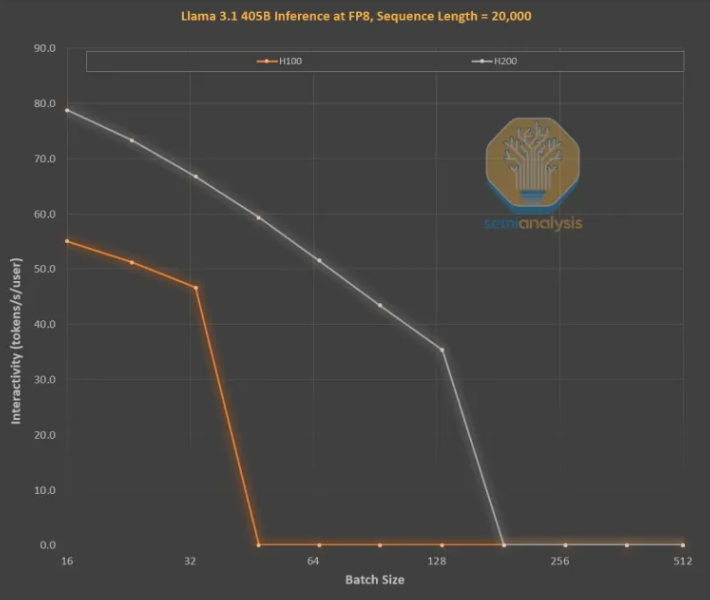

更高的內存帶寬(H200爲4.8TB/s,H100爲3.35TB/s)使得所有可比較的批處理大小的交互性普遍提高了43%。

由於H200運行的批處理大小比H100更大,每秒生成的token數增加了3倍,成本降低了約3倍。這種差異主要是由於KVCache限制了總批處理大小。

更大的內存容量對性能的提升是巨大的。兩款GPU之間的性能和經濟差異遠大於其參數規格所顯示的:

推理模型的用戶體驗可能較差,因爲請求和響應之間存在明顯的等待時間。如果能夠顯著加快推理時間,將提高用戶的使用意願和付費意願。

硬件通過中代內存升級實現3倍的性能提升是驚人的,遠超摩爾定律、黃氏定律或我們所見過的任何其他硬件改進速度。

最強大的模型能夠收取比性能稍差的模型高得多的溢價。前沿模型的毛利率超過70%,而開源競爭的落後模型的利潤率則低於20%。推理模型不必只進行一個鏈式思考。搜索功能可以擴展來提高性能,就像在O1Pro和O3中所做的那樣。這使得更智能的模型能夠解決更多問題,併爲每個GPU產生更多的收入。

當然,英偉達並非唯一可以增加內存容量的公司。ASIC也可以做到這一點,事實上,AMD可能處於更有利的地位,因爲其MI300X、MI325X和MI350X的內存容量通常比英偉達更高,分別爲192GB、256GB和288GB,但英偉達擁有名爲NVLink的祕密武器。

NVL72的重要性在於,它允許72個GPU在同一問題上協同工作,共享內存,且延遲極低。世界上沒有其他加速器具有全互連的交換能力。

英偉達的GB200NVL72和GB300NVL72對於實現許多關鍵功能至關重要:

更高的交互性,降低了每個思維鏈的延遲。

72個GPU可以分散KVCache,從而實現更長的思維鏈(提高智能)。

批處理大小的可擴展性比典型的8GPU服務器好得多,從而降低了成本。

在同一問題上工作以提高準確性和模型性能的樣本量更多。

因此,NVL72的tokenomics提高了10倍以上,尤其是在長推理鏈上。KVCache佔用內存對經濟效益是致命的,但NVL72是唯一將推理長度擴展到10萬個以上token的方法。

GB300:供應鏈重塑

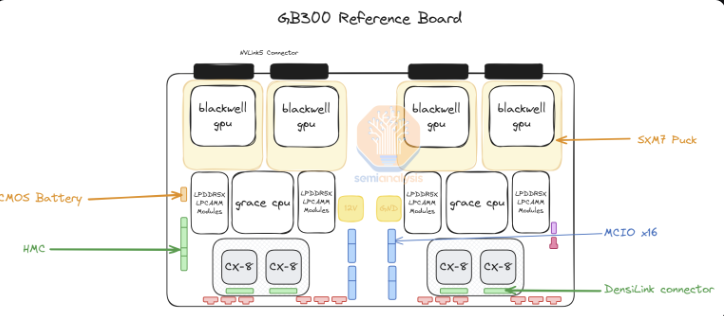

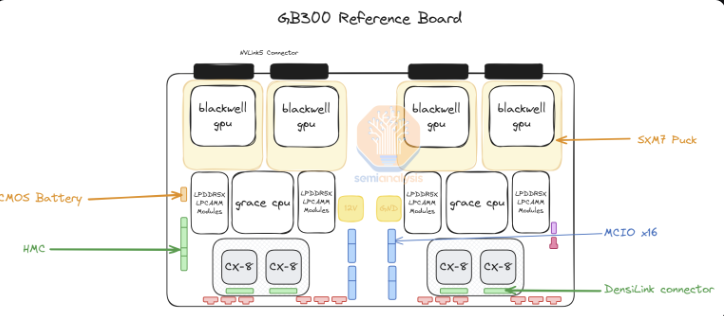

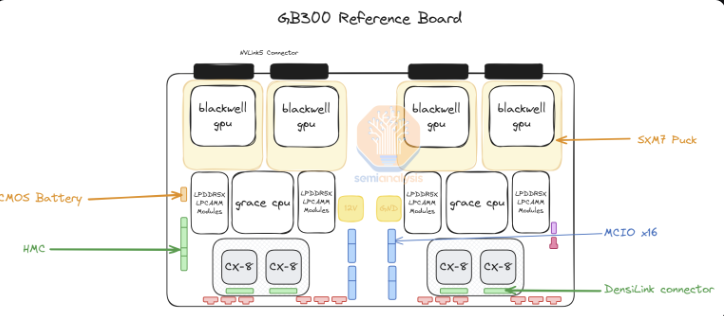

對於GB300,英偉達提供的供應鏈和內容發生了巨大變化。對於GB200,英偉達提供整個Bianca板(包括Blackwell GPU、Grace CPU、512GB LPDDR5X、VRM內容),以及交換托盤和銅背板。

對於GB300,英偉達只提供“SXM Puck”模塊上的B300、BGA封裝的Grace CPU,以及HMC,後者將來自美國初創公司Axiado,而不是GB200的Aspeed。終端客戶現在將直接採購計算板上的剩餘組件,第二層內存將使用LPCAMM模塊,而不是焊接的LPDDR5X。美光將成爲這些模塊的主要供應商。交換托盤和銅背板保持不變,英偉達完全供應這些組件。

轉向SXM Puck爲更多OEM和ODM參與計算托盤提供了機會。以前只有緯創和富士康可以製造Bianca計算板,而現在更多的OEM和ODM可以參與其中。緯創是ODM形式的最大輸家,因爲他們失去了Bianca板的份額。對於富士康來說,Bianca板份額的損失被他們是SXM Puck和SXM Puck的插槽的獨家製造商這一事實所抵消。英偉達正試圖爲Puck和插槽引入其他供應商,但尚未下達任何其他訂單。

另一個重大變化是VRM內容。雖然SXM Puck上有一些VRM內容,但大部分板載VRM內容將由超大規模公司/OEM直接從VRM供應商處採購。由於業務模式的轉變,Monolithic Power Systems將會失去市場份額。

英偉達還在GB300平臺上提供800G ConnectX-8NIC,在InfiniBand和以太網上提供雙倍的擴展帶寬。英偉達之前由於上市時間複雜性和在Bianca板上放棄啓用PCIe Gen6而取消了GB200的ConnectX-8。

ConnectX-8與ConnectX-7相比有了巨大的改進。它不僅具有2倍的帶寬,還具有48個PCIe通道,而不是32個PCIe通道,從而實現了獨特的架構,例如風冷式MGX B300A。此外,ConnectX-8具有SpectrumX能力,而在之前的400G產品中,SpectrumX需要效率較低的Bluefield3DPU。

GB300對超大規模公司影響

GB200和GB300的延遲對超大規模公司的影響意味着,許多從Q3開始的訂單將轉移到英偉達新的、更昂貴的GPU上。截至上週,所有超大規模公司都決定採用GB300。部分原因是GB300的性能更高,但也有一部分原因是由於他們能夠掌控自己的命運。

由於上市時間挑戰以及機架、冷卻和電源供應/密度的重大變化,超大規模公司不允許在服務器級別對GB200進行過多更改。這導致Meta放棄了從博通和英偉達多來源NIC的希望,轉而完全依賴英偉達。在其他情況下,如谷歌,他們放棄了內部NIC,轉而只使用英偉達。

對於超大規模公司中習慣於優化從CPU到網絡,再到螺絲和金屬板的所有成本的數千人組織來說,這簡直是不可思議的。

最令人震驚的例子是亞馬遜,他們選擇了一種非常不理想的配置,其TCO比參考設計更差。亞馬遜由於使用PCIe交換機和效率較低的200G彈性光纖適配器NIC,需要風冷,因此無法像Meta、谷歌、微軟、Oracle、X.AI和Coreweave那樣部署NVL72機架。由於其內部NIC,亞馬遜不得不使用NVL36,由於更高的背板和交換機內容,每個GPU的成本也更高。總而言之,由於其圍繞定製的限制,亞馬遜的配置並不理想。

現在有了GB300,超大規模公司可以定製主板、冷卻等更多組件。這使得亞馬遜能夠構建自己的定製主板,該主板採用水冷,並集成了以前風冷的組件,如Astera Labs PCIe交換機。隨着更多組件採用水冷,以及在25年第三季度終於在K2V6400G NIC上實現HVM,這意味着亞馬遜可以迴歸NVL72架構,並大大提高其TCO。

雖然超大規模公司必須設計、驗證和確認更多內容,這是最大的缺點。這很容易成爲超大規模公司有史以來必須設計的最複雜的平臺(谷歌的TPU系統除外)。某些超大規模公司將能夠快速設計,但其他團隊速度較慢的公司則落後。儘管市場報告有取消情況,但我們認爲微軟由於設計速度較慢,是部署GB300最慢的公司之一,他們仍在第四季度購買一些GB200。

客戶支付的總價格差異很大,因爲組件從英偉達的利潤堆疊中被提取出來,轉移到ODM。ODM的收入受到影響,最重要的是,英偉達的毛利率也會在全年發生變化。

參考資料:https://semianalysis.com/2024/12/25/nvidias-christmas-present-gb300-b300-reasoning-inference-amazon-memory-supply-chain/