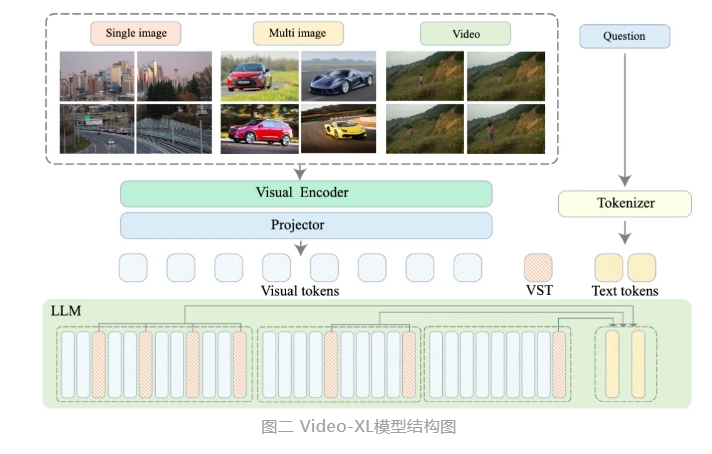

北京智源人工智能研究院聯合上海交通大學、中國人民大學、北京大學和北京郵電大學等高校推出了一款名爲Video-XL的超長視頻理解大模型。這款模型是多模態大模型核心能力的重要展示,也是向通用人工智能(AGI)邁進的關鍵步驟。與現有多模態大模型相比,Video-XL在處理超過10分鐘的長視頻時,展現了更優的性能和效率。

Video-XL利用語言模型(LLM)的原生能力,對長視覺序列進行壓縮,保留了短視頻理解的能力,並在長視頻理解上顯示出了卓越的泛化能力。該模型在多個主流長視頻理解基準評測的多項任務中均排名第一。Video-XL在效率與性能之間實現了良好平衡,僅需一塊80G顯存的顯卡即可處理2048幀輸入,對小時級長度視頻進行採樣,並在視頻“海中撈針”任務中取得了接近95%的準確率。

Video-XL有望在電影摘要、視頻異常檢測、廣告植入檢測等應用場景中展現廣泛的應用價值,成爲長視頻理解的得力助手。該模型的推出,標誌着長視頻理解技術在效率和準確性上邁出了重要一步,爲未來長視頻內容的自動化處理和分析提供了強有力的技術支持。

目前,Video-XL的模型代碼已經開源,以促進全球多模態視頻理解研究社區的合作和技術共享。

論文標題:Video-XL: Extra-Long Vision Language Model for Hour-Scale Video Understanding

論文鏈接:https://arxiv.org/abs/2409.14485

模型鏈接:https://huggingface.co/sy1998/Video_XL

項目鏈接:https://github.com/VectorSpaceLab/Video-XL