人工智能正以驚人的速度顛覆各個行業,視頻製作領域也不例外。近期,AI視頻生成模型的出現引發了廣泛關注,甚至有人聲稱它將徹底改變好萊塢的未來。

然而,這項技術的實際能力究竟如何?香港中文大學和騰訊的研究人員通過"VideoGen-Eval"項目,對當前主流AI視頻生成模型進行了全面評估,揭示了這一新興技術的真實水平。

研究團隊從多個維度對AI視頻生成模型進行了測試,包括文本與視頻的一致性、畫面組合、場景過渡、創造性、風格化、穩定性以及動作多樣性等。結果顯示,雖然AI在某些方面取得了顯著進展,但距離完美還有相當長的路要走。

各大視頻模型綜合對比如下:

在文本生成視頻(T2V)方面,Gen-3、Kling v1.5和 Minimax 表現出色,其中 Minimax 在文本控制方面表現突出,尤其在人物表情、運鏡、多鏡頭生成和主體動態方面表現優異。

Gen-3在控制光照、紋理和電影化技巧方面表現出色,而 Kling v1.5則在視覺效果、可控性和動作能力之間取得了良好的平衡。

Pika1.5在特定視頻特效生成方面表現突出, 例如膨脹、融化、爆炸等特效。

對比視頻如下:

提示詞:Static camera, a glass ball rolls on a smooth tabletop

提示詞:FPV aerial shot, the sunshine shines on the snow capped mountains, a quiet atmosphere

提示詞:Zooming in hyper-fast to a red rose and showcase the details of its petals

目前市面上的 AI 視頻生成模型主要有兩類:閉源和開源。閉源模型就相當於那些高科技公司的獨門祕籍,比如 Runway 公司的 Gen-3和 LumaLabs 公司的 Dream Machine,這些模型通常生成視頻質量更高,功能更強大,但你不花點錢就別想體驗。

而開源模型就相當於江湖上的武功祕籍,人人都可以學習,比如 Open-Sora 和 EasyAnimate,雖然效果可能不如閉源模型,但勝在免費開源,人人都能參與進來。

"VideoGen-Eval" 這個項目測試了各種 AI 視頻生成模型,包括文本生成視頻 (T2V)、圖像生成視頻 (I2V) 和視頻生成視頻 (V2V) 三個方面。結果發現,這些模型雖然在某些方面取得了很大進步,比如畫面質量、動作自然度和與文本描述的匹配度,但離我們想象中的完美,還差得遠呢!

先說優點,現在的 AI 已經可以生成一些簡單的視頻了, 比如你輸入“一隻泰迪熊在超市裏走動,鏡頭逆時針旋轉”,AI 就能生成一段鏡頭旋轉的泰迪熊視頻。聽起來是不是挺神奇的?但是,如果你想讓 AI 生成一些複雜的場景,比如“一個人在游泳池裏游泳,水花四濺”,或者“三隻猴子在森林裏跳躍,兩隻鸚鵡在樹叢中飛翔”,那 AI 就開始抓瞎了。

究其原因,主要是因爲 AI 對物理規律、空間關係、物體屬性等方面的理解還不到位。 比如你讓 AI 生成一段“玻璃球在桌子上滾動”的視頻,AI 可能就不知道玻璃球應該怎麼滾才符合物理規律,最後生成的視頻就會很奇怪。

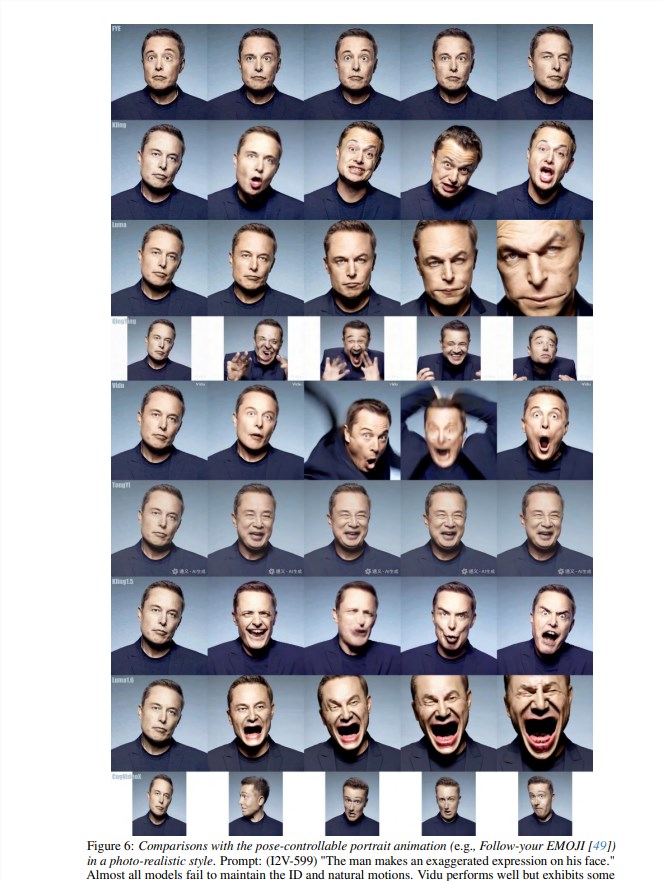

除此之外,AI 在處理快速運動、人物表情、多人物交互等方面也存在很大問題。 比如你想讓 AI 生成一段打棒球的視頻,結果 AI 生成的畫面可能就會非常鬼畜,人物動作完全不協調,甚至連棒球都飛到九霄雲外去了。

更別提那些需要 AI 發揮想象力和創造力的場景了, 比如你想讓 AI 生成一段“一個人被五彩煙霧包圍”的視頻,AI 可能就只會生成一堆亂七八糟的顏色,根本看不出是什麼東西。總之,目前所有模型都無法做到完美, 在處理複雜動作、多物體交互、物理模擬、語義理解、精細控制等方面仍存在很大挑戰。

完整測評視頻點此查看:https://ailab-cvc.github.io/VideoGen-Eval/#text-to-video