在人工智能快速發展的今天,一個名爲ORYX的多模態大型語言模型正在悄然改變我們對AI理解視覺世界能力的認知。這個由清華大學、騰訊和南洋理工大學研究人員聯合開發的AI系統,堪稱視覺處理領域的"變形金剛"。

ORYX,全稱Oryx Multi-Modal Large Language Models,是一個專門設計用於處理圖像、視頻和3D場景時空理解的AI模型。它的核心優勢在於能夠像人類一樣,不僅理解視覺內容,還能洞察內容之間的關聯和背後的故事。

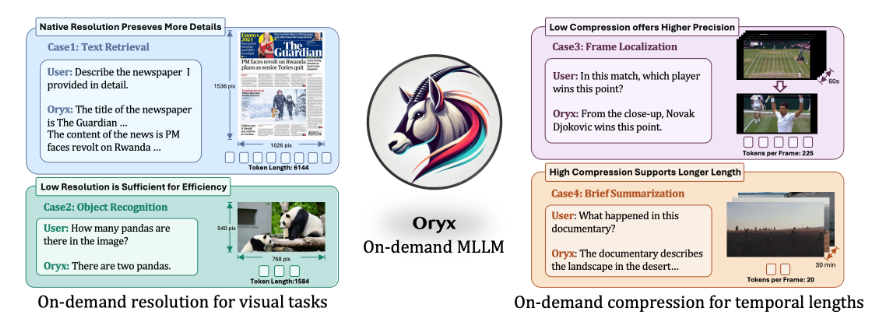

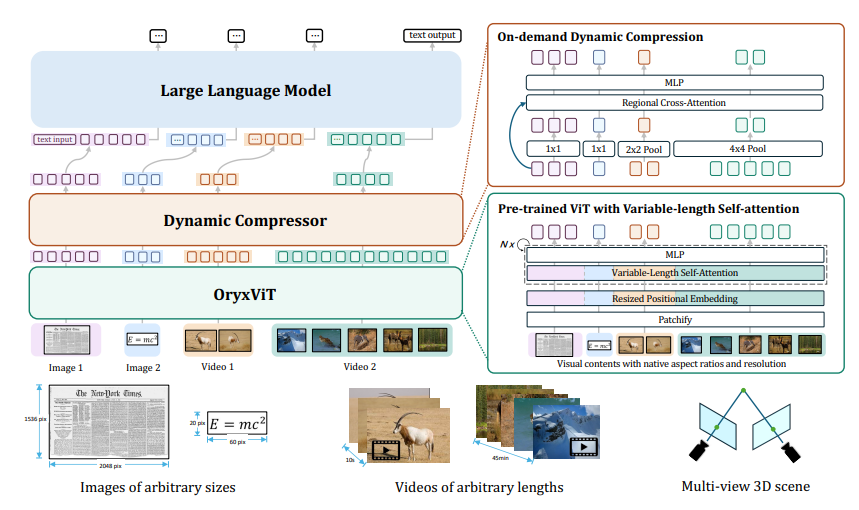

這個AI系統的一大亮點是其處理任意分辨率視覺輸入的能力。無論是模糊的老照片還是高清視頻,ORYX都能輕鬆應對。這得益於其預訓練模型OryxViT,它能將不同分辨率的圖像轉換爲AI可理解的統一格式。

更令人驚歎的是ORYX的動態壓縮能力。面對長時間的視頻輸入,它能夠智能地壓縮信息,保留關鍵內容而不失真。這就像是將一本厚重的書精煉成一張內容豐富的便籤卡,既保留了核心信息,又大大提高了處理效率。

ORYX的工作原理主要依賴於兩個核心組件:視覺編碼器OryxViT和動態壓縮模塊。前者負責處理多樣化的視覺輸入,後者則確保長時間視頻等大容量數據能夠被高效處理。

在實際應用中,ORYX展現出了驚人的潛力。它不僅能深入理解視頻內容,包括對象、情節和動作,還能準確把握3D空間中物體的位置和關係。這種全方位的視覺理解能力,爲未來的人機交互、智能監控、自動駕駛等領域帶來了無限可能。

值得一提的是,ORYX在多個視覺-語言基準測試中表現卓越,尤其在圖像、視頻和多視圖3D數據的空間和時間理解方面,展現出了領先優勢。

ORYX的創新之處不僅在於其強大的處理能力,更在於它爲AI視覺理解開闢了新的範式。它能夠以原生分辨率處理視覺輸入,同時通過動態壓縮技術高效處理長視頻,這種靈活性和效率是其他AI模型難以企及的。

隨着技術的不斷進步,ORYX有望在未來的AI領域扮演更加重要的角色。它不僅將幫助機器更好地理解我們的視覺世界,還可能爲人類認知過程的模擬提供新的思路。

論文地址:https://arxiv.org/pdf/2409.12961