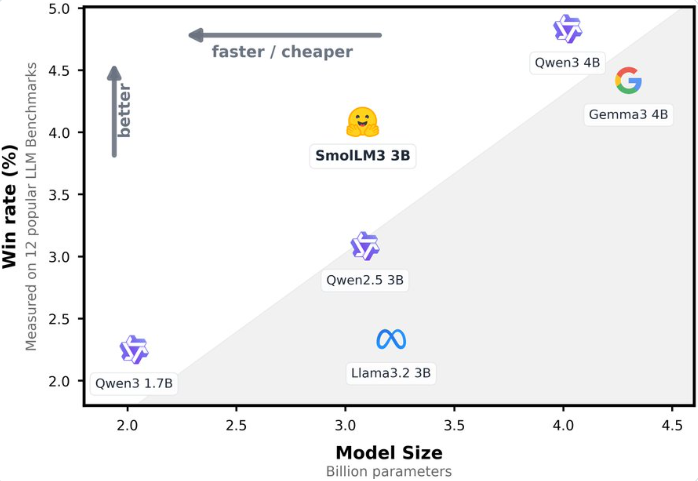

最近、Hugging Faceは新たにオープンソースの言語モデル「SmolLM3」を正式リリースしました。このモデルは3Bパラメータを持つ軽量な大規模言語モデル(LLM)で、優れた性能と効率的な設計により業界から注目を集めています。SmolLM3は、同レベルのLlama-3.2-3BやQwen2.5-3Bよりも多くのベンチマークテストで優れているだけでなく、より大きな4BパラメータモデルであるGemma3と同等の性能を示しています。

アドレス:https://huggingface.co/blog/smollm3

3Bパラメータ、4Bモデルに匹敵する性能

SmolLM3は3Bパラメータのデコーダー専用Transformerモデルで、グループ化クエリアテンション(GQA)とNoPE技術を用いて最適化され、効率的な推論と長文処理の両方を備えています。このモデルは、ウェブ、コード、数学、推論データを含む多様な11.2兆トークンのデータセット上で予測トレーニングされています。これにより、知識、推論、数学、コードなどさまざまな分野での強力な性能が確保されています。公式によると、SmolLM3はHellaSwag、ARC、BoolQなどの知識と推論ベンチマークテストで上位にランクインしており、Qwen3-4BやGemma3-4Bなどの4Bパラメータモデルと比べても劣らず、小規模モデルの驚異的な可能性を示しています。

二つの推論モード、多様なタスクへの柔軟な対応

SmolLM3は独自の二つの推論モード「考える(think)」と「考えない(no-think)」をサポートしています。思考モードを有効にすると、AIME2025(36.7% vs 9.3%)、LiveCodeBench(30.0% vs 15.2%)、GPQA Diamond(41.7% vs 35.7%)などの複雑なタスクにおいて顕著な向上が見られます。このような柔軟な推論モードにより、タスクのニーズに応じて動的に調整でき、速度と深層推論の両方をバランスよく保つことが可能となり、速い質問応答から複雑な問題解決までのさまざまなシナリオに対応できます。

128Kの長文処理、6言語のスムーズな切り替え

SmolLM3は長文処理において優れた性能を発揮し、トレーニング時には64Kの文脈をサポートし、YaRN技術によって最大128Kトークンまで拡張可能です。Ruler64kテストでは長文処理能力が非常に強いため、その性能が証明されています。また、英語、フランス語、スペイン語、ドイツ語、イタリア語、ポルトガル語の6言語をネイティブにサポートし、アラビア語、中国語、ロシア語でも少量のトレーニングが行われており、多言語タスクにおける優れた性能を示しています。Global MMLU、Flores-200などのテストでは、SmolLM3の多言語能力は同レベルのモデルの中で最も上位に位置しています。これはグローバルなアプリケーションシーンに信頼性あるサポートを提供しています。

完全オープンソース、開発者エコシステムの支援

Hugging Faceは一貫してオープンソースの精神を守っており、SmolLM3はモデルの重みだけでなく、トレーニングデータの混合、トレーニング設定、コードも完全にオープンソース化しています。開発者はHugging Faceのsmollmストレージから詳細な情報を取得できます。このような透明性のある「トレーニングマップ」により、学術研究や商業利用の障壁が大幅に低下し、開発者は公開されたデータセットやフレームワークに基づいてモデルを再現または最適化することが可能です。AIbaseによると、この取り組みにより、オープンソースAIエコシステムがさらに繁栄し、エッジデバイスへの導入やカスタマイズアプリケーションに多くの可能性が生まれるでしょう。

効率的な設計、エッジデバイスの新しい選択肢

SmolLM3は効率的な推論を目的として設計されており、グループ化クエリアテンション機構により推論時のKVキャッシュの使用量を大幅に削減しています。WebGPUのサポートを組み合わせることで、ブラウザやエッジデバイスで動作するのに最適です。より大きなモデルと比較して、SmolLM3はパフォーマンスと計算コストの間で「パレート最適」なバランスを取っています。教育、コード作成、カスタマーサポートなどの場面において、高コストパフォーマンスのソリューションを提供しています。

業界への影響と今後の展望

SmolLM3のリリースは、小規模言語モデルが性能と効率の点で重要な突破を遂げたことを示しています。オープンソースの特性、長文処理のサポート、多言語能力により、SmolLM3は学術研究、スタートアップ、中小企業にとって理想的な選択肢となっています。AIbaseは、SmolLM3が教育、カスタマーサービス、ローカライズドプロビジョニングなどの分野で応用の波を引き起こすと予想しています。また、完全オープンソースのトレーニングプロセスは、さらに多くの開発者がAIモデルの最適化と革新に参加するよう刺激することになるでしょう。

SmolLM3は3Bパラメータで4Bモデルと同等の性能を実現し、小さなモデルが効率的なAI分野で無限の可能性を持っていることを示しています。Hugging Faceはトレーニングの詳細とデータをオープンソースすることで、業界に透明性と協力を示すモデルを提供しました。SmolLM3がより多くの実際のシナリオでどのように機能するかを期待し、今後のアップデートにも引き続き注目していきます。

結び