最近、NVIDIA、香港大学およびマサチューセッツ工科大学の研究チームは、拡散言語モデルの推論効率を向上させるための新技術「Fast-dLLM」を発表しました。従来の自己回帰モデルとは異なり、拡散言語モデルはテキストノイズを段階的に除去する方法でテキストを生成し、1回の反復で複数の単語を生成できるため、全体的な効率が高くなります。しかし、実際の応用では、多くのオープンソースの拡散言語モデルの推論速度は依然として自己回帰モデルに劣っており、主な要因はキーバルュー(KV)キャッシュのサポートの欠如や、並列デコード時に生成品質が低下することです。

KVキャッシュは自己回帰モデルでよく使われる推論加速技術であり、以前に計算されたアテンション状態を保存・再利用することで、重複計算を大幅に削減し、生成速度を向上させます。しかし、拡散言語モデルは双方向のアテンションメカニズムを使用しているため、直接KVキャッシュを適用するのは難しいです。Fast-dLLMアーキテクチャの革新点は、テキスト生成プロセスを複数のブロックに分割することです。各ブロックには一定数のトークンが含まれています。このブロックごとの生成方式により、モデルはあるブロックを生成する前に他のブロックのKVキャッシュを事前に計算して保存でき、これにより重複計算を回避します。

KVキャッシュメカニズムは推論速度を効果的に向上させますが、並列デコード時には生成品質が低下することがあります。これは、拡散型モデルがデコード時に条件独立性を仮定しているため、トークン間に複雑な依存関係がある可能性があるからです。これを解決するために、Fast-dLLMは信頼度に基づく並列デコード戦略を提案しました。各デコードステップにおいて、モデルは各トークンの信頼度を計算し、しきい値を超える信頼度を持つトークンのみを選んでデコードします。この戦略により、高い信頼度の下で安全に並列デコードを行うことができ、生成テキストの一貫性と正確性を維持できます。

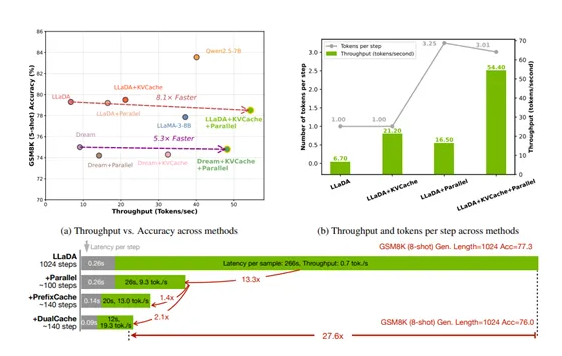

Fast-dLLMの性能を検証するために、研究者はNVIDIA A100 80GB GPU上でLLaDAとDreamという2つの拡散言語モデルを全面的に評価し、数学的推論やコード生成などのタスクを含めました。KVキャッシュメカニズムのテストでは、ブロックサイズが32の場合、モデルのスループットは54.4tokens/sで、精度は78.5%でした。並列デコードのテストでは、動的しきい値戦略が固定トークン数ベースラインよりも優れていました。全体的に見ると、LLaDAモデルはGSM8KタスクにおいてKVキャッシュによる加速で3.2倍、並列デコードによる加速で2.5倍となり、両者を組み合わせた場合の加速は8.1倍に達し、生成長さが1024の際のエンドツーエンドの加速は27.6倍にもなりました。すべてのテスト結果から、Fast-dLLMは加速しながらも生成品質の安定性を保っていることが確認されました。

ポイント:

🌟 Fast-dLLM技術はNVIDIAや香港大学などによって開発され、拡散言語モデルの推論速度を向上させました。

⚡ KVキャッシュメカニズムはアテンション状態を保存・再利用し、冗長な計算を減らして生成効率を著しく向上させます。

📈 信頼度に基づく並列デコード戦略はテキスト生成の一貫性と正確性を確保し、モデル全体のパフォーマンスを向上させます。