バイトダンスは、3億パラメータのモデルであるVINCIE-3Bをオープンソースとして発表しました。このモデルは、文脈連続画像編集をサポートしており、内部のMM-DiTアーキテクチャに基づいて開発されました。このモデルは従来の画像編集の制約を突破し、単一のビデオデータから文脈感知型の画像編集能力を学習することを初めて実現しました。専門的なセグメンテーションや修復モデルに依存することなく、トレーニングデータを生成することができました。VINCIE-3Bのリリースにより、クリエイティブデザイン、映像後処理、コンテンツ生成分野に新たな可能性が生まれました。AIbaseはその技術的特徴、応用場面、業界への影響を深く分析しています。

技術的革新:ビデオから文脈編集へ

従来の画像編集モデルは通常、タスク固有のデータパイプラインに依存しており、専門的なモデル(セグメンテーションや修復など)によってトレーニングデータを生成する必要がありました。これはコストが高く、プロセスも複雑です。VINCIE-3Bは画期的にビデオから直接学習し、ビデオを交差マルチモーダルシーケンス(テキスト+画像)に変換することで、文脈感知型の画像編集を実現します。具体的な技術的特徴は以下の通りです:

- ビデオ駆動型トレーニング:VINCIE-3Bはビデオの連続フレームを使用し、自動的にテキスト説明と画像シーケンスを抽出してマルチモーダルトレーニングデータを作成します。この方法により、従来の手法に必要な専門モデルに依存しなくなり、データ準備コストを大幅に削減できます。

- ブロック因果拡散トランスフォーマー(Block-Causal Diffusion Transformer):モデルはブロック因果アテンションメカニズムを採用し、テキストと画像ブロック間で因果アテンションを行い、ブロック内では双方向アテンションを行います。この設計により情報が効率よく流れ、時間系列の因果関係を保ちながら処理が可能です。

- 3つの代理タスクによるトレーニング:VINCIE-3Bは次のフレーム予測、現在のフレームセグメンテーション予測、次のフレームセグメンテーション予測の3つのタスクを通じてトレーニングされます。これにより、動的なシーンや物体の関係性をより正確に理解できるようになります。

- クリーン画像とノイズ画像の組み合わせ:拡散モデルにおいてノイズ画像の入力を解決するために、VINCIE-3Bはクリーン画像とノイズ画像の両方を入力し、アテンションマスクを利用してノイズ画像がクリーンな文脈に基づいて生成されるようにします。これにより編集品質が向上します。

性能テストにおいて、VINCIE-3BはKontextBenchおよび新しい多ラウンド画像編集ベンチマークで業界トップレベル(SOTA)を達成しました。特にテキストの忠実度、キャラクターの一貫性、および複雑なシーンの編集(動的な物体の移動など)において優れた性能を示しました。高品質な編集画像を生成する平均時間は約4秒であり、推論効率は同様のモデルよりも約8倍速いです。

オープンソースエコシステム:グローバルな開発者を支援

VINCIE-3Bの完全なコード、モデル重み、トレーニングデータ処理プロセスは、2025年6月14日にGitHubとarXivで公開され、開発者は申請を通じて完全なデータセットを取得できます(連絡先メール:yangsiqian@bilibili.com)。モデルはバイトダンスのMM-DiT(3Bおよび7Bパラメータバージョン)から初期化され、Apache2.0ライセンスで提供されており、非商業用途には利用可能です。商業用途については、バイトダンスに問い合わせて許諾を得る必要があります。

バイトダンスはまた、多ラウンド画像編集ベンチマークをリリースし、リアルなシナリオケースを含んでおり、コミュニティがモデルの性能を検証・最適化することを奨励しています。SNS上では、開発者がVINCIE-3Bのオープンソース化を歓迎しており、「ビデオから学ぶ」方法が低コストなAIコンテンツ制作の新ルートを切り開いたと評価しています。

応用場面:クリエイティブと生産性の両立

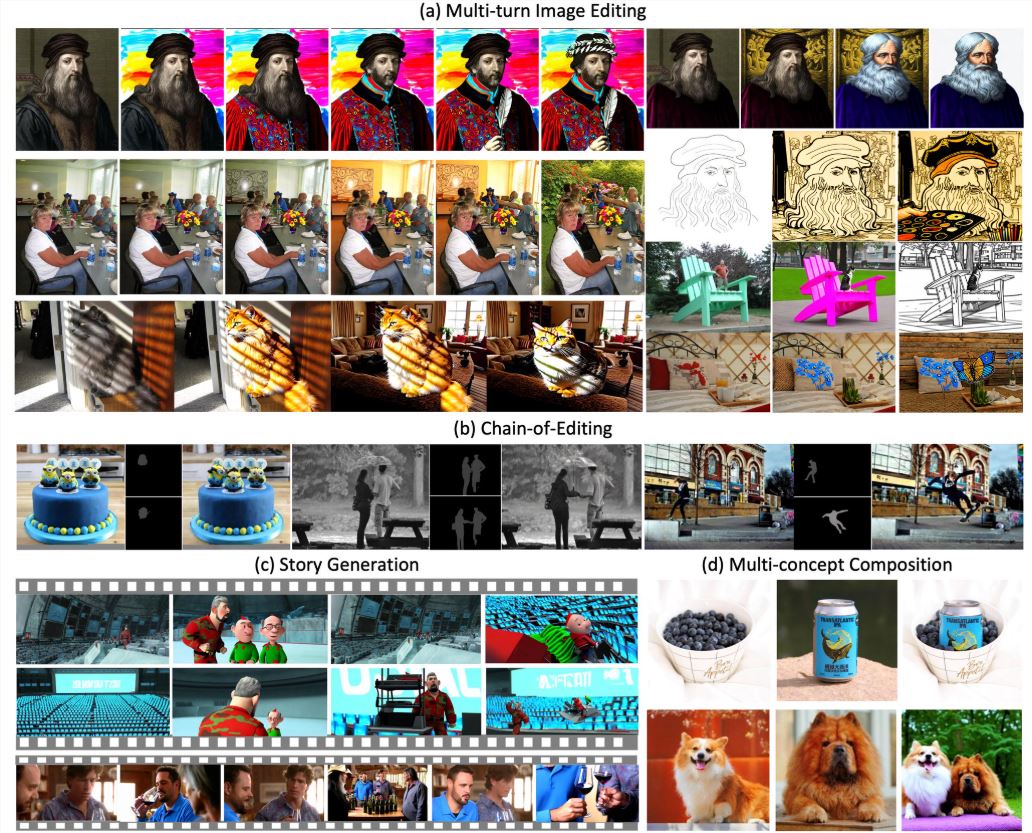

VINCIE-3Bはテキストと以前の画像に基づく連続編集をサポートし、さまざまなシナリオに適用できます:

- 映像後処理:ビデオフレームからキャラクターや物体を抽出し、異なるシーンに適応する連続的な編集を行うことができます。例えば、室内から室外へのキャラクターの移動を保持しながら、光と視点を一致させます。

- ブランドマーケティング:製品やロゴをさまざまな背景(カフェ、屋外広告板など)に配置し、自動的に照明、影、透視を調整し、多様なシナリオでの宣伝素材作成を簡略化します。

- ゲームとアニメーション:テキスト命令によってキャラクターの動作やシーン要素を調整し、迅速なプロトタイピングとアニメーションプレビューをサポートします。

- SNSコンテンツ:1枚の画像を基に動的なシーケンスを生成し、静止画のキャラクター画像を動的な絵文字に変換することが可能です。

たとえば、「赤いドレスの女の子を公園から海辺に移動させ、ドレスの模様を維持し、夕焼けの光に調整してください」という指示を出せば、自然に統合された画像が生成され、ドレスの細部や光の描写が非常にリアルになります。AIbaseのテスト結果によると、VINCIE-3Bは複数ラウンドの編集において90%以上のキャラクター一貫性を維持できており、FLUX.1Kontext [pro]の複雑なシナリオにおける表現よりも優れています。

限界と課題

VINCIE-3Bは優れた性能を示していますが、いくつかの限界もあります:

- 複数ラウンド編集の制限:過度のラウンド編集は視覚的な偽像を引き起こし、画像品質を低下させる可能性があります。ユーザーは5ラウンド以内に編集を完了することを推奨します。

- 言語サポート:現在のモデルは主に英語の指示に対応しており、中国語や他の言語のテキスト忠実度はやや劣ります。バイトダンスは今後のバージョンで多言語対応を改善する予定です。

- 著作権問題:トレーニングデータの一部は公開ビデオから取得されており、潜在的な著作権紛争のリスクがあります。商用利用時は内容の合法性を確保する必要があります。

AIbaseはVINCIE-3Bを使用する際、提供されているKontextBenchデータセットを使ってテストを行い、プロンプト設計を最適化することを推奨しています。商業利用者はバイトダンスに問い合わせて明確なライセンス条件を確認することをお勧めします。

業界への影響:画像編集の枠組みの再構築

VINCIE-3Bのリリースは、画像編集が静的から動的、単一から文脈連続へと変化するという枠組みの転換を示しています。Black Forest LabsのFLUX.1Kontext(静的画像編集に特化)と比較すると、VINCIE-3Bはビデオから学習することで、より強力な動的シーン理解を実現し、時間的連続性が必要なアプリケーションに特に適しています。BilibiliのAniSora V3(アニメビデオ生成に特化)と比較すると、VINCIE-3Bはより汎用的であり、現実的なシーンと仮想コンテンツ生成の両方に対応しています。

バイトダンスのオープンソース戦略は、AIクリエイティブツール分野における地位をさらに強化しています。AIbaseは、VINCIE-3Bの「ビデオから画像へのトレーニング」方法が他の企業にも類似の道を提示する可能性があり、AIモデル開発コストを低下させ、クリエイティブ業界の民主化を促進すると考えています。

huggingface:https://huggingface.co/ByteDance-Seed/VINCIE-3B