科学文献のタスクにおける大規模言語モデル(LLM)の性能を人間の好みに基づいて評価するための新しいオープンプラットフォーム「SciArena」がリリースされました。初期の結果は、異なるモデル間で顕著なパフォーマンスの差が存在していることを示しています。

SciArenaは、ユーレイ大学、ニューヨーク大学、アレン人工知能研究所の研究者によって共同開発され、特有およびオープンソースのLLMが科学文献のタスクを処理する効果を体系的に評価することを目的としています。この分野での体系的な評価の空白を埋めています。

従来のベンチマークテストとは異なり、SciArenaはChatbot Arenaの方法に倣って、実際に研究者が評価を行っています。ユーザーが科学的な質問を提出すると、モデルが生成し、引用を含む長文の回答が2つ提示され、そのどちらが優れているかをユーザーが判断します。関連する文献はカスタムのScholarQA検索プロセスによって取得されます。

これまでに、自然科学、工学、生命科学、社会科学の分野で102人の研究者から1万3千以上の評価が収集されており、概念の説明や文献検索などのさまざまなトピックに関する質問が含まれています。

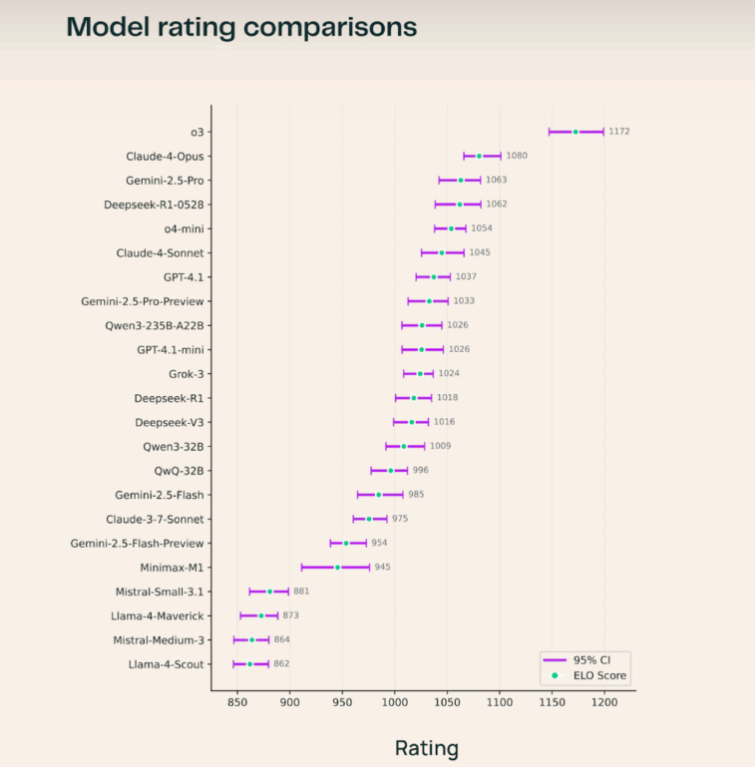

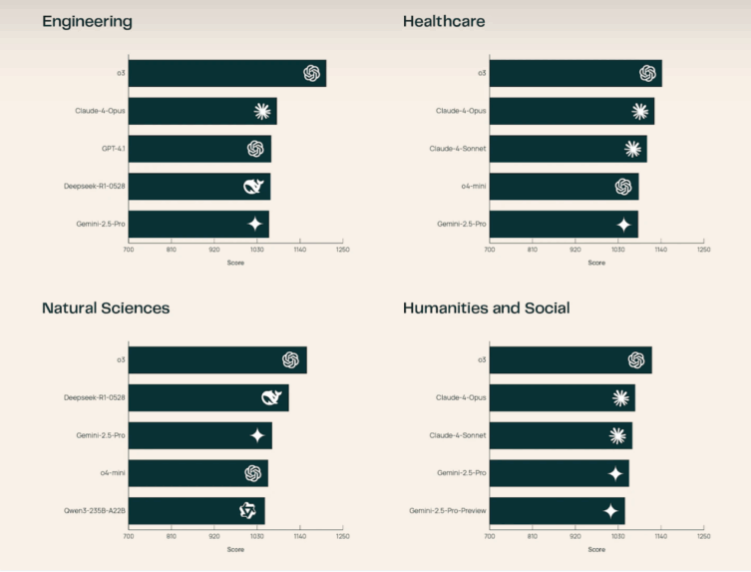

現在のランキングでは、OpenAIのo3モデルがトップに立ち、Claude-4-OpusやGemini-2.5-Proを上回っています。オープンソースモデルの中で、Deepseek-R1-0528が突出しており、そのパフォーマンスは多くの専有システムを上回っています。研究チームは、o3が自然科学と工学分野で特に優れたパフォーマンスを示していると指摘しています。また、研究者たちは、評価において引用が主張と正しく一致しているかどうかが最も重視されていることを発見しました。答えの長さなどの要因は、SciArenaにおいてChatbot ArenaやSearch Arenaなど他のプラットフォームよりも影響が小さくなっています。

これらの進展にもかかわらず、自動評価は依然として課題です。このチームは、言語モデルが他のモデルの回答を判断する能力をテストするための新しいベンチマーク「SciArena-Eval」をリリースしました。しかし、最高性能のモデルでも、約65%の時間しか人間の好みと一致しないため、現時点でのLLM-as-a-Judgeシステムが科学分野で抱える限界が浮き彫りになっています。