人工知能の発展に伴い、大規模言語モデル(LLM)の応用はますます広がっていますが、現在の推論方法には依然として多くの制限があります。従来の逐次生成方式では、トークンを一個ずつ生成するため効率が低く、現代のハードウェア並列計算能力を十分に活用できません。この問題を解決するために、カーネギーメロン大学(CMU)とNVIDIAの研究チームは、マルチバース(Multiverse)という新しい生成モデルを発表しました。これは本質的にLLMの推論の理解を変えようとする試みで、原生的な並列生成を目指しています。

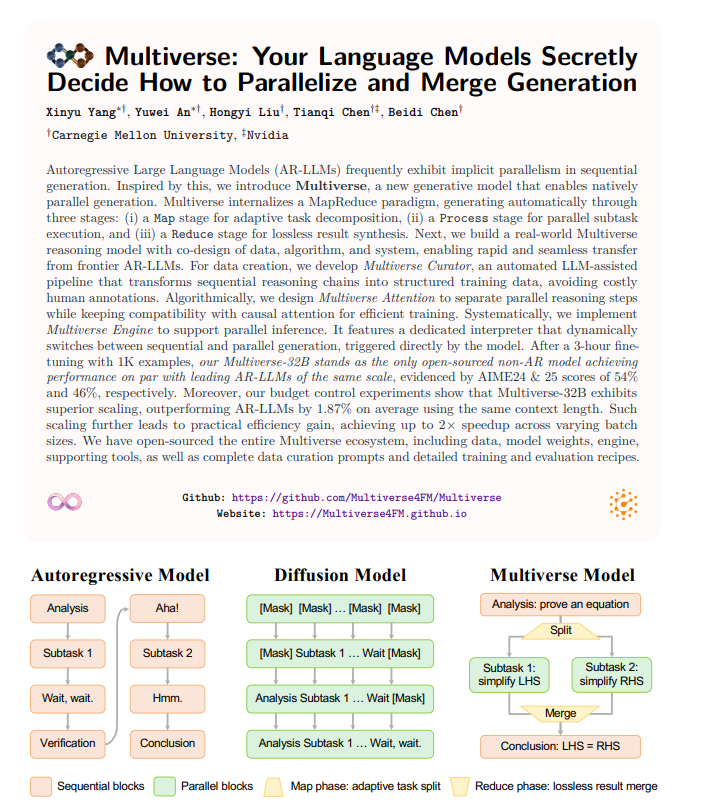

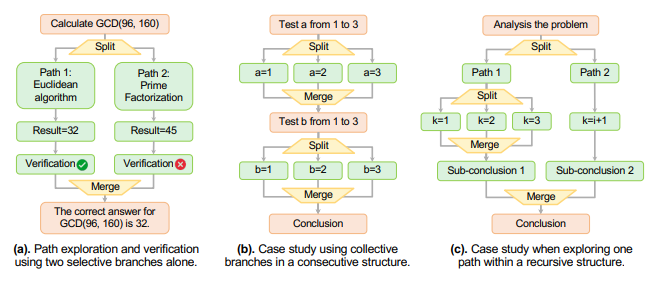

マルチバースは単に生成速度を速めるだけでなく、モデルのアーキテクチャそのものを再考しました。研究者たちは、現在の主流の大規模言語モデルが生成プロセスの中で潜在的に並列性を持っていることを発見しました。この発見に基づいて、マルチバースフレームワークはMapReduceのような構造を取り入れ、生成プロセスを三つの段階に分けました:タスクの適応的分割、サブタスクの並列実行、そして損失のない結果の統合。このような設計により、計算リソースの潜在能力を最大限に引き出し、より効率的な推論プロセスを実現します。

実験データによれば、マルチバース-32Bモデルは同じ文脈長さにおいて、逐次生成モデルよりも約2%性能が向上しました。これにより、マルチバースは速度だけでなく拡張性においても優れた成果を示し、異なるバッチサイズにおいて最大で2倍の速度向上を達成することが可能です。さらに、この技術をより広範に活用するために、研究チームはマルチバースエコシステム全体をオープンソース化し、データ、モデル重み、トレーニング詳細などを公開し、他の研究者がさらに探索できるようにしました。

実際の応用では、マルチバースは生成要件に応じて柔軟に調整でき、特定の制御ラベルを用いて順次生成と並列生成の動的切り替えが可能になります。これにより、生成された内容の連続性と論理性が保たれます。この技術の登場により、自然言語処理分野に新たな活力が注がれ、今後の実用化におけるパフォーマンスを期待しています。